数据预处理查看源代码讨论查看历史

|

数据预处理(data preprocessing)是指在主要的处理以前对数据进行的一些处理。如对大部分地球物理面积性观测数据在进行转换或增强处理之前,首先将不规则分布的测网经过插值转换为规则网的处理,以利于计算机的运算。另外,对于一些剖面测量数据,如地震资料预处理有垂直叠加、重排、加道头、编辑、重新取样、多路编辑等。

- 中文名:数据预处理

- 外文名:data preprocessing

- 定 义:主要的处理以前对数据进行处理

- 方 法:数据清理,数据集成,数据变换等

- 目 标:格式标准化,异常数据清除

- 特 点:提高了数据挖掘模式的质量

基本介绍

现实世界中的大规模数据往往是杂乱的,主要表现为: [1]

1.不完整性:数据属性值遗漏或不确定。

2.不一致性:由于原始数据的来源不同,数据定义缺乏统一标准,导致系统间数据内涵不一致,例如:同--属性的命名、单位、字长却不相同。

3.有噪声:数据中存在异常(偏离期望值)。

4.冗余性:数据记录或属性的重复。

该类数据无法直接进行数据挖掘,或挖掘结果差强人意。为了提高数据挖掘的质量产生了数据预处理技术。 数据预处理有多种方法:数据清理,数据集成,数据变换,数据归约等。这些数据处理技术在数据挖掘之前使用,大大提高了数据挖掘模式的质量,降低实际挖掘所需要的时间。

数据的预处理是指对所收集数据进行分类或分组前所做的审核、筛选、排序等必要的处理。

预处理内容

数据审核

从不同渠道取得的统计数据,在审核的内容和方法上有所不同。

对于原始数据应主要从完整性和准确性两个方面去审核。完整性审核主要是检查应调查的单位或个体是否有遗漏,所有的调查项目或指标是否填写齐全。准确性审核主要是包括两个方面:一是检查数据资料是否真实地反映了客观实际情况,内容是否符合实际;二是检查数据是否有错误,计算是否正确等。审核数据准确性的方法主要有逻辑检查和计算检查。逻辑检查主要是审核数据是否符合逻辑,内容是否合理,各项目或数字之间有无相互矛盾的现象,此方法主要适合对定性(品质)数据的审核。计算检查是检查调查表中的各项数据在计算结果和计算方法上有无错误,主要用于对定量(数值型)数据的审核。

对于通过其他渠道取得的二手资料,除了对其完整性和准确性进行审核外,还应该着重审核数据的适用性和时效性。二手资料可以来自多种渠道,有些数据可能是为特定目的通过专门调查而获得的,或者是已经按照特定目的需要做了加工处理。对于使用者来说,首先应该弄清楚数据的来源、数据的口径以及有关的背景资料,以便确定这些资料是否符合自己分析研究的需要,是否需要重新加工整理等,不能盲目生搬硬套。此外,还要对数据的时效性进行审核,对于有些时效性较强的问题,如果取得的数据过于滞后,可能失去了研究的意义。一般来说,应尽可能使用最新的统计数据。数据经审核后,确认适合于实际需要,才有必要做进一步的加工整理。[2]

数据审核的内容主要包括以下四个方面:

1.准确性审核。主要是从数据的真实性与精确性角度检查资料,其审核的重点是检查调查过程中所发生的误差。

2.适用性审核。主要是根据数据的用途,检查数据解释说明问题的程度。具体包括数据与调查主题、与目标总体的界定、与调查项目的解释等是否匹配。

3.及时性审核。主要是检查数据是否按照规定时间报送,如未按规定时间报送,就需要检查未及时报送的原因。

4.一致性审核。主要是检查数据在不同地区或国家、在不同的时间段是否具有可比性。[3]

数据筛选

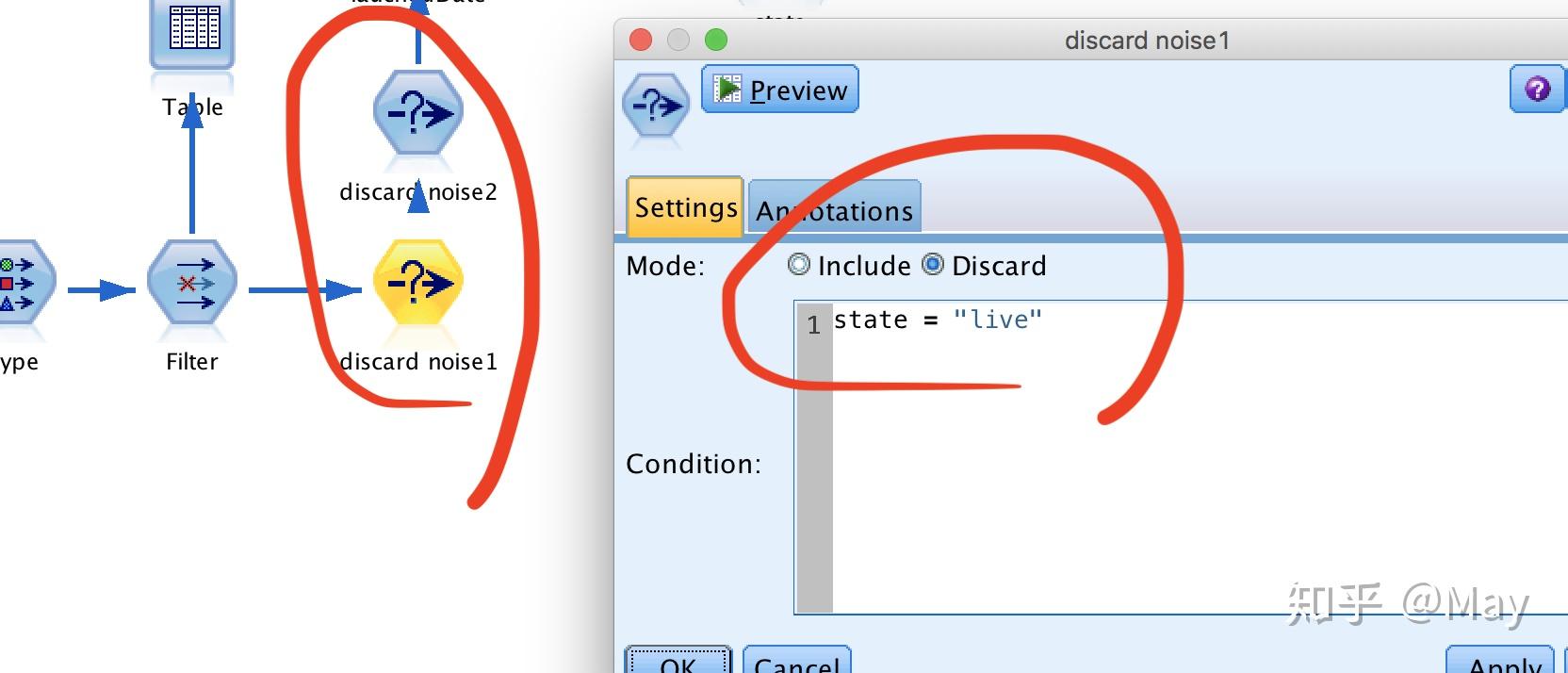

对审核过程中发现的错误应尽可能予以纠正。调查结束后,当数据发现的错误不能予以纠正,或者有些数据不符合调查的要求而又无法弥补时,就需要对数据进行筛选。数据筛选包括两方面的内容:一是将某些不符合要求的数据或有明显错误地数据予以剔除;二是将符合某种特定条件的数据筛选出来,对不符合特定条件的数据予以剔除。数据的筛选在市场调查、经济分析、管理决策中是十分重要的。

数据排序

数据排序是按照一定顺序将数据排列,以便于研究者通过浏览数据发现一些明显的特征或趋势,找到解决问题的线索。除此之外,排序还有助于对数据检查纠错,为重新归类或分组等提供依据。在某些场合,排序本身就是分析的目的之一。排序可借助于计算机很容易的完成。

对于分类数据,如果是字母型数据,排序有升序与降序之分,但习惯上升序使用得更为普遍,因为升序与字母的自然排列相同;如果是汉字型数据,排序方式有很多,比如按汉字的首位拼音字母排列,这与字母型数据的排序完全一样,也可按笔画排序,其中也有笔画多少的升序降序之分。交替运用不同方式排序,在汉字型数据的检查纠错过程中十分有用。

对于数值型数据,排序只有两种,即递增和递减。排序后的数据也称为顺序统计量。

方法

数据清理

数据清理例程通过填写缺失的值、光滑噪声数据、识别或删除离群点并解决不一致性来“清理”数据。主要是达到如下目标:格式标准化,异常数据清除,错误纠正,重复数据的清除。

数据集成

数据集成例程将多个数据源中的数据结合起来并统一存储,建立数据仓库的过程实际上就是数据集成。

数据变换

通过平滑聚集,数据概化,规范化等方式将数据转换成适用于数据挖掘的形式。

数据归约

数据挖掘时往往数据量非常大,在少量数据上进行挖掘分析需要很长的时间,数据归约技术可以用来得到数据集的归约表示,它小得多,但仍然接近于保持原数据的完整性,并结果与归约前结果相同或几乎相同。

数据预处理 引用错误:没有找到与</ref>对应的<ref>标签 是数据挖掘一个热门的研究方面,毕竟这是由数据预处理的产生背景所决定的--现实世界中的数据几乎都脏数据。

视频

数据预处理概述